Blog

Themen

Was ist Dunkle Materie?

Was ist Dunkle Energie?

Was hat den Urknall ausgelöst?

Diese Fragen begleiten mich seit ich mich das erste Mal für Astrophysik interessiert habe. Wie schön wäre es, die Fragen endlich zufriedenstellend beantworten zu können. Ich habe mir bereits zwei Theorien zu diesen Themen ausgedacht und sie ebenfalls hier als Blog-Artikel niedergeschrieben. Jedoch lassen sich beide Theorien nicht überprüfen und trotz dessen, dass sie sehr interessant und unterhaltsam sind und in sich schlüssig wirken, ist es doch sehr frustrierend, nie zu wissen ob sie womöglich stimmen. Deshalb freue ich mich endlich mit der "magischen" 3. Theorie eine tatsächlich überprüfbare These aufzustellen.

Zeit neu denken

Zeit zu definieren war schon immer schwer. Wir haben sie mehr oder weniger als 4. Dimension akzeptiert und mit ihr herumgerechnet. Laut Einstein bewegt sich alles exakt mit Lichtgeschwindigkeit durch die Raumzeit und der Anteil der Bewegung in der Zeit ist abhängig von der Bewegung im Raum. Dadurch wussten wir, dass Zeit unterschiedlich schnell vergehen kann. Trotzdem wussten wir immer noch nicht was Zeit ist und haben gefühlt auch nicht weiter nachgehakt.

Seit langer Zeit wird nach dem mysteriösen Unbekannten gesucht und vermutet wird ein exotisches Teilchen, das mit „normaler“ Materie nicht reagiert. Es gab schon viele Theorien darüber, z.B. Miniatur-Schwarze Löcher die kleiner als ein Atom seien sollen und so nur durch ihre Schwerkraft auffallen, ohne bzw. nur super selten dabei mit normaler Materie zu kollidieren. Eine noch abenteuerlichere Theorie ist das Wirken von Schwerkraft aus Paralleluniversen.

In laufenden Forschungsprojekten wird nach unbekannten, exotischen Elementarteilchen jenseits des Standardmodells gesucht. Mit Hilfe von dicht gepackten Atomen, die tief im Inneren der Erde eingegraben sind und von hoch sensiblen Messinstrumenten beobachtet werden, wird jegliche Interaktion mit einem Teilchen gemessen. In der Hoffnung, dass bei einer Kollision die Energiesignatur eine andere ist, als die, die man schon kennt wie z.B. die von Neutrinos, die es auch schaffen dorthin zu gelangen.

Definition des Begriffs Materie

Um über den Begriff Dunkle Materie zu sprechen, sollte man zunächst die „normale“ Materie definieren: Materie ist alles, was man sehen und anfassen kann und aus den Elementen des Periodensystems besteht; also Planeten, Sonnen, Galaxien, auch Gas- und Staubwolken, … Alle haben etwas gemeinsam: Sie interagieren miteinander. Das heißt sie kollidieren und gehen chemische Verbindungen ein.

Warum Dunkle Materie?

Nein wir sind nicht bei Star Wars, wo es eine helle und eine dunkle Seite der Macht gibt, sondern ganz einfach, weil man sie nicht sieht und das heiß nicht nur mit den Augen nicht, sondern es wechselwirkt einfach überhaupt nicht mit Materie. Der einzige Grund warum wir uns den Begriff Dunkle Materie überhaupt ausdenken mussten ist, weil man seine Anziehungskraft messen und sehen kann.

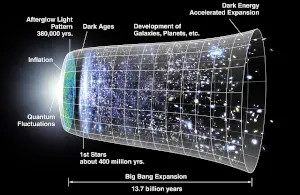

Alles beginnt mit einem großen Knall, dem Urknall. Der hat die 3 Raumdimensionen unseres Universums aufgespannt und den Zeitpfeil losgetreten. Wenn wir jedoch nach einem Verursacher des Urknalles suchen, kommen wir (egal was wir als Antwort finden) in ein kausales Problem: Wer hat den Verursacher verursacht...?

Meine sehr provokante These lautet: Unser Universum ist das Innere eines Schwarzen Lochs in einem übergeordneten Universum und entstand im selben Moment wie das Schwarze Loch selbst. Dies ist zwar eine von mir eigens entwickelte Theorie, jedoch habe ich mittlerweile herausgefunden, dass auch andere diese Theorie bereits viel früher hatten, wie der polnische theoretische Physiker Nikodem Popławski. Das ermutigt mich jedoch nur möglicherweise richtig zu liegen. Ich gehe in diesem Artikel auf viele Eigenschaften unseres Universums ein, die durch ein solches Konstrukt einfach zu erklären wären, wie die Quantenfluktuation, die Dunkle Energie bzw. Inflation, die Rotation, die Antimaterie, das Informationsparadoxon und einiges mehr.

Jede Beule erzeugt auch eine Delle

Als Analogie kann man eine Beule in einem Auto auch als Delle betrachten, wenn man von der anderen Seite des Blechs schaut. Da muss es auch in der Raumzeit ein Äquivalent zu einem Loch geben. Meine Vermutung ist, dass die Raumzeitkrümmung die bei einem Schwarzen Loch aus unserer Perspektive ins Unendliche verschwindet einen Schnittpunkt im Inneren besitzt, von dem die Krümmung wieder zurück in eine entspannte Raumzeit wechselt und eine Blase bildet. Also wird im Inneren eines Schwarzen Lochs eine eigene Raumzeit aufgespannt, die abhängig von der Raumzeitkrümmung im übergeordneten Universum ist. Je größer das Schwarze Loch bzw. die verursachte Raumzeitkrümmung, desto größer die innere Blase.

So hätten wir einen Verursacher gefunden, der durch ein kausales Ereignis unseren Urknall erklären könnte. Das heißt die Supernova eines Sterns und der Zerfall in ein Schwarzes Loch haben womöglich unseren Urknall im inneren des Schwarzen Loches ausgelöst. Damit hätten wir das Informationsparadoxon aufgelöst, da die Materie die in ein Schwarzes Loch fällt somit nicht unwiderruflich zerstört wird, sondern im inneren Universum weiter existieren könnte.

Ein Quantencomputer kann Information verarbeiten und nutzt dafür Quantenphysikalische Gesetzte. Dabei werden nicht wie bei einem Klassischen Computer 1 und 0 mittels logischer Schaltgatter hin und her geschupst und sich die Ergebnisse im Arbeitsspeicher oder auf Festplatten gemerkt. Ein Quantencomputer manipuliert die Eigenschaften eines, bzw. mehrerer kleinen Teilchen und misst anschließend die daraus resultierenden Eigenschaften als Ergebnis. Die Schwierigkeit ist dabei die richtigen Manipulationen anzuwenden um danach auch ein nutzbares Ergebnis auslesen zu können welches die Lösung eines konkreten Problems ist. Deswegen müssen alle Algorithmen neu entwickelt werden, denn es kann nichts aus der klassischen Informatik wiederverwendet werden.

Außer die Manipulation der Teilchen und das Auslesen tut der Quantencomputer nichts, die eigentliche Arbeit lässt er die Quantenphysik selbst machen, deshalb ist er auch so unglaublich schnell im Lösen bestimmter Problemklassen. Die größte Schwierigkeit dabei ist die Bedingungen zu erschaffen damit die Teilchen sich in der Form manipulieren lassen wie ein Quantencomputer das braucht. Die Zustände in der Quantenphysik sind sehr instabil und kurzlebig und die geringste Interaktion eines Teilchens mit irgendetwas anderem würde den Zustand und die Eigenschaften des Teilchens verändern. Dann wäre jegliche Weiterberechnung damit sinnfrei, weil das gesuchte Ergebnis bereits zerstört ist.

Berechnung durch Manipulation der Eigenschaften von Teilchen

Wie sehen diese Manipulationen aus und wie kann man damit komplexe Probleme berechnen?

Silizium zu verarbeiten ist dank der Halbleiter-Technologie schon seit Jahrzehnten perfektioniert und ist unproblematisch herzustellen. Dass jetzt ein Quantenmodul auf dieser Grundlage entwickelt wurde, bringt die Quantencomputer-Technologie weit nach vorn. Leider benötigt das neue Quantenmodul noch immer eine starke Abkühlung des Materials nahe dem absoluten Nullpunkt, um die Reaktionsfreudigkeit der Elektronen zu senken, damit der sensible Quantenzustand nicht gestört wird.

Trotzdem kommt diese Q-Bit-Spin-Variante mit wesentlich besseren Temperaturen von ungefähr 1 K (Kelvin) oder auch (-272,15 °C) aus, im Gegensatz zu den supraleitende Q-Bit-Varianten die Temperaturen von 20 mK (-273,13 °C) benötigen. Außerdem schätzen die Forscher die Temperatur nochmal drastisch verbessern zu können, auf -269 °C. Der Unterschied mag sich gering anhören, es ist aber in diesen niedrigen Temperaturen ein massiver Unterschied. Das ist wie mit den Höchstgeschwindigkeiten bei Autos. Die zusätzlich benötigte Energie um von 300 auf 310 km/h zu kommen, ist vergleichbar mit der Energie um von 100 auf 200 km/h zu beschleunigen. Je näher am extremen, desto größer der Unterschied! Ein weiterer Vorteil der Q-Bit-Spin-Variante ist die Platzeinsparung, da die Q-Bits auf sehr viel geringerem Raum eingefangen werden können, als bei den supraleitenden Q-Bit-Varianten.

Es war ein sehr langer Weg bis sich die derzeit bekannteste und komplexeste Verdichtung von Materie im Universum bilden konnte.

Was ist das Gehirn eigentlich, bzw. was macht es? Es verarbeitet Informationen, die es in Form von elektrischen Impulsen, ausgelöst durch chemische Reaktion unserer Wahrnehmungsorgane, empfängt. Diese Signale werden in die entsprechend zuständigen Regionen weitergeleitet und dort verarbeitet. Sie durchlaufen eine unendlich komplex vernetzte Struktur - das neuronale Netzwerk - bei der jeder Verbindungspunkt ein Neuron ist und nach bestimmten Regeln und je nach Verbindung das eintreffende Signal weiterleitet oder auch nicht weiterleitet.

Aber woher kommt es? War es schon immer da? Nein! Die erste Form der Signalverarbeitung begann schon bei den Bakterien. Diese haben Empfangsmoleküle (Rezeptoren) in der Zellwand, die bei Stimulation (chemische Prozesse) mit der Außenwelt zu Handlungsentscheidungen der Bakterie führen kann. Die Bakterie kann sich dadurch zu einer Futterquelle hin bewegen oder sich von Giftstoffen entfernen. Natürlich ist sich die Zelle nicht bewusst darüber und kann demnach nicht selbst entscheiden, aber die erlangte Fähigkeit ist evolutionär vorteilhaft, denn sie kann dadurch besser Nahrung finden und stirbt nicht bei der ersten giftigen Substanz in der Nähe. Also hat sich die Fähigkeit, von außen stammende Informationen zu interpretieren, durchgesetzt.

Daraus bildeten sich später die Nervenzellen (Neurone), die ursprünglich in der äußeren Hautschicht unmittelbar der Umgebung ausgesetzt waren und sich darauf spezialisierten, Reize zu empfangen und weiterzuleiten.

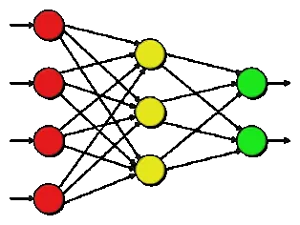

Ein Neuronales Netzwerk ist der Funktionsweise eines Gehirns nachempfunden und besteht alleine aus einzelnen Neuronen und ihren Verbindungen untereinander.

Seine Stärken sind die Muster- und Gesichtserkennung. Ein klassischer Computer hat Schwierigkeiten damit, Gesichter von Individuen korrekt zuzuordnen und ist auf vielerlei Bedingungen angewiesen z.B. eine gute Bildqualität, das kennt man vom biometrischen Passfoto. Dieses muss aus einer bestimmten und optimalen Perspektive das Gesicht zeigen. Zusätzlich können Emotionen und damit einhergehende Gesichtsverzerrungen die Erkennungswahrscheinlichkeit negativ beeinflussen. Wir Menschen dagegen, können ein Individuum in allen Gefühlslagen, auch bei Dunkelheit und von der Seite zuverlässig erkennen.

Der Aufbau eines Neuronalen Netzes

Es gib drei verschiedene Typen von Neuronen, auch Units genannt.

Input-Units: Nehmen das Eingangs-Signal entgegen. Im Falle der Bilderkennung wird dort die digitale Signatur (Eingangs Vector) des Bildes angelegt.

Hidden-Units: Sind beliebig viele Schichten von Neuronen zwischen dem Input- und den Output-Neuronen. Die Informationen die dort liegen, sind von außen nicht sichtbar.

Output-Units: Sie liegen außen und repräsentieren das Endergebnis, welches nach außen getragen wird. (Ausgangs Vector)

Zuerst schaut ihr auf die Seite vom Wildfly und kopiert euch den Adresslink der Zip-Datei vom Download der Version die ihr haben möchtet. Ich habe die Anleitung für 2 Versionenen auspobiert.

Also wir wechseln in das Verzeichnis /opt/ und ziehen und die Zip-Datei mit dem Befehl wget:

cd /opt/ wget https://download.jboss.org/wildfly/14.0.1.Final/wildfly-14.0.1.Final.zip unzip wildfly-14.0.1.Final.zip rm wildfly-14.0.1.Final.zip mv wildfly-14.0.1.Final/ wildfly

Doch bevor wir uns weiter mit der Wildfly-Installation beschäftigen, sollten wir prüfen ob und in welcher Version Java installiert ist. Mit java -verion könnt ihr das überprüfen. Falls Java bereits installiert ist und ihr die richtige Version habt, könnt ihr den kommenden Abschnitt überspringen und den folgenden Haken setzen.

Ich gehe für die Installation der PostgreSQL Datenbank und dem Wildfly Applikationsserver von dem Stand aus, den ihr nach der Durchführung der Anleitung im Artikel: Linux Debian Server einrichten und absichern habt!

PostgreSQL-Datenbank installieren und einrichten

Die Installation ist sehr einfach, folgender Befehl reicht aus:

apt-get install postgresql postgresql-client

Danach existiert ein default-User und eine default-Datenbank, beide heißen postgres. Wir möchten aber einen eigenen User erzeugen, der eine eigene Datenbank bekommt auf die nur er Zugriff hat. Dafür erzeugen wir als root aus der Shell heraus einen neuen User. Danach erzeugen wir als postgres nochmal den selben User und erzeugen anschließend für ihn eine Datenbank. Der Einfachheit halber könnt ihr in folgenden Eingabefeldern euren gewählten Benutzernamen und Datenbanknamen eingeben, damit sich die kopierbaren Befehle und Konfigurationen für euch anpassen:

Wir werden in diesem Artikel den ssh-Zugang für den Benutzer root sperren, Den ssh-Port verändern und einen neuen Benutzer erzeugen, der alleiniges Recht besitzt, sich über ssh zu verbinden und der sich ausschließlich mit dem Private-/Public-Key-Verfahren authentifizieren lässt.

Falls ihr einen Server bei netcup gehostet habt, wird ssh schon vorinstalliert sein und ihr könnt die Installation überspringen und beim Erstellen des ssh-users beginnen.

SSH Installation und root den Zugang ermöglichen

apt-get install openssh-server

Dann gebt ihr dem root die Erlaubnis per ssh zuzugreifen. Dafür öffnet ihr folgende Datei:

vim /etc/ssh/sshd_config

Dort ändert ihr folgende Zeile ab:

PerminRootLogin yes

Damit die Änderungen wirksam sind, muss der ssh-Service neu gestartet werden:

service sshd restart

Jetzt könnt ihr euch von egal wo mit eurem Server über PuTTY verbinden. Diese Schritte sind bei der Debian-Version von netcup schon voreingerichtet und ihr könnt mit dem nächsten Punkt weitermachen.

Um euch eine vollständige Anleitung zur Einrichten eines Linux Debian Servers, mit kopierbaren Befehlen bieten zu können, habe ich mir einen Test-Server eingerichtet, den ich als VirtualBox-VM laufen habe.

Für diese Anleitung gehe ich davon aus, dass ihr euch irgendwo einen Server gehostet habt und falls nicht, ihr die Linux-Grundinstallation schon durchgeführt habt und euch im Besitz des root-Passwortes befindet!

Download

Auf debian.org kann ein aktuells Image heruntergeladen werden.

Einstieg – Erste Anmeldung auf dem Linux Server

Wenn ihr einen Server gehostet habt, werdet ihr euch das aller erste mal mit dem root Benutzer über SSH mittels PuTTY anmelden.

Das ist eine riesige Sicherheitslücke und deshalb solltet ihr direkt nach dem Update auf die neueste Version, einen SSH-User anlegen und mit Private-/Public-Key-Verfahren authentifizieren und den Zugang per SSH für root sperren. Grundsätzlich ist es vorteilhaft für jede Anwendung einen eigenen Benutzer zu haben, der alleine das Recht besitzt die Anwendung zu administrieren.